O rastreador de olhar em conjunto com o teclado virtual já se tornou uma ferramenta muito utilizada por indivíduos com doenças degenerativas e por jogadores de videogames de realidade aumentada. O que resta, agora, é encontrar maneiras de tornar a digitação por meio do olhar mais rápida e confortável para o usuário. Essa é a área de pesquisa de Andrew Kurauchi e tema de sua tese de doutorado defendida no Instituto de Matemática da Universidade de São Paulo e orientada pelo professor Carlos Hitoshi Morimoto.

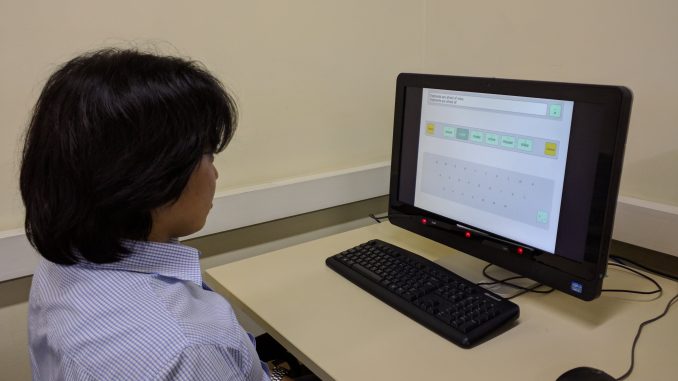

Com isso em mente, o pesquisador propôs o EyeSwipe, um software de teclado virtual que funciona de uma maneira diferenciada dos tradicionais. Ao invés do usuário olhar para cada letra separadamente para montar as palavras, o EyeSwipe funciona de maneira parecida com a função “swipe” de digitação nos smartphones. O usuário olha para diferentes letras e o software se encarrega de dar sugestões de palavras que ele acha que foram escritas. Tal método se mostrou mais eficaz em termos de rapidez de digitação e conforto para o usuário.

Como funcionam

Tradicionalmente, as formas mais convencionais de digitação utilizando o rastreador de olhar funcionam da seguinte maneira: o usuário tem na frente de si uma tela que mostra um teclado e, para digitar uma palavra, é preciso que ele fixe o olhar em cada letra por um determinado período de tempo (aproximadamente meio segundo). Dessa forma, a interface compreende que o usuário quer selecionar aquela letra, e não está apenas passando a visão pelo teclado.

Essa forma de digitação, porém, pode ser lenta. O EyeSwipe, proposto por Kurauchi, se mostrou mais eficaz em termos de velocidade de digitação. Ao invés de ter de esperar um determinado tempo para cada letra ser selecionada, o EyeSwipe se baseia no caminho do olhar. O usuário deve apenas passar o olho por cada letra que deseja para compor a palavra, sem a necessidade de passar um tempo encarando cada uma delas. Assim, o software, por meio do caminho do olhar do indivíduo, tenta adivinhar a palavra que ele está digitando. As possíveis opções de palavras aparecem rapidamente logo acima do teclado e o usuário seleciona a correta.

“Comparado com outros métodos, acho que o grande diferencial é a ideia de usar as palavras inteiras. As linguagens em geral costumam ter bastante repetição, e com formações de sílabas e coisas assim a gente consegue extrair mais informação do que com simplesmente letras soltas”, afirma o pesquisador.

Eyeswipe 1 e 2

Foram desenvolvidas duas variações de interações com o programa: o EyeSwipe 1 e o EyeSwipe 2. A diferença entre eles é simples e está na forma de comunicar à interface que uma palavra foi iniciada ou finalizada. No EyeSwipe 1 essa indicação é feita com alguns gestos específicos com o olhar que o usuário deve realizar. Já no EyeSwipe 2, essa indicação é feita de forma mais implícita. Quando o usuário desvia o olhar da área da tela em que fica o teclado, o programa assume que ele terminou a digitação e mostra as opções de palavras que é provável que ele tenha escrito.

O EyeSwipe 2 foi proposto durante o desenvolvimento e teste do EyeSwipe 1, visando um aprimoramento deste. Os dados, de fato, mostram grandes diferenças de velocidades de digitação. Considerando aqui uma palavra como sendo o conjunto de cinco caracteres, com os métodos mais convencionais de digitação com o olhar o usuário é capaz de digitar, em média, entre 10 e 15 palavras por minuto (ppm). Com o EyeSwipe 1, as velocidades mais altas chegaram a 21 ppm, enquanto a média foi cerca de 12 ppm. Já com o EyeSwipe 2, as velocidades máximas chegaram a 32 ppm, e a média a 14 ppm.

Público e impacto social

O Eyeswipe é destinado a qualquer usuário que não possa usar um teclado comum para se comunicar. Esse grupo abrange desde pessoas com doenças que afetam as funções motoras até usuários de videogames de realidade virtual que não possuem um teclado físico no momento do jogo. “É um pouco essa ideia de um design universal. O que a gente assume é: o que ele [o usuário] sabe fazer? A gente assume que o que ele consegue fazer naquele momento é mexer os olhos”, explica Andrew.

Por outro lado, o pesquisador reconhece uma maior necessidade por parte do público com doenças degenerativas como a Esclerose Lateral Amiotrófica (ELA) ou a Síndrome do Encarceramento. “Às vezes elas conseguem mexer só o olho e todas as funções cognitivas estão preservadas funcionando, mas não conseguem nem se comunicar. Então acho q isso me deu bastante motivação de querer fazer alguma coisa”.

O pesquisador menciona o recém falecido físico Stephen Hawking e destaca a importância de se dar voz a essas pessoas. “A sociedade perde quando a gente não ouve o que essas pessoas também têm para falar. Então acho que a motivação foi poder ajudar as pessoas a terem voz e a comunicarem o que elas estão pensando”, diz ele.

Chegar nesse público, porém, nem sempre é a tarefa mais fácil. Andrew destaca a necessidade de uma maior integração na universidade, onde em teoria seria possível interagir com pessoas de diferentes áreas, como a medicina. Na prática, ainda falta um próximo passo para chegar nas pessoas que necessitam da tecnologia. “Esse é um grande desafio pra gente, de tentar dar esse passo a mais que nem sempre rende publicação mas é onde a gente consegue chegar no impacto de verdade, social”.

Próximos passos

Uma das dificuldades observadas é que pessoas com menos experiência em digitação com movimentos do olhar levam mais tempo tanto para aprender a utilizar quanto na utilização em si. Um possível aprimoramento é tornar mais fácil o aprendizado, de forma que um usuário inexperiente possa ter um primeiro contato com o software e já conseguir se comunicar.

Outro empecilho reside na questão financeira. Os rastreadores de olhar muitas vezes são caros devido à importação, o que impede que essa tecnologia consiga atingir as pessoas que necessitam. Kurauchi pensa que uma possível solução para esse problema seria tentar trabalhar com apenas o que o indivíduo já possui em seu computador, como a câmera, para que a aquisição possa se tornar mais barata.

É muito importante que o EyeSwipe chegue nas pessoas para que seja possível dar os próximos passos em relação ao seu desenvolvimento e aprimoramento. É preciso que as pessoas o utilizem para que se possa levantar problemas, requisitos e demandas que irão conduzir futuras pesquisas.

“Pra mim o desafio agora que eu acabei a tese – e acho que tem varias possibilidades pela frente – é de dar esse passo a mais de chegar nas pessoas, eventualmente em associações de pessoas com deficiência”, afirma o pesquisador. “Acho que é interessante tanto a gente entrar em contato quanto eventualmente alguém que tiver interesse também entrar em contato com a gente. Acho que o próximo passo é fazer isso acontecer de verdade”.

Faça um comentário